搜索

人类和动物的生物脑如何从感官当中庞杂的信息,提取出有价值的部分,并且从中分析出我们正在朝哪里运动?这是一项对于我们的生存至关重要的能力。

许多感官本身具有方向表征的特性,比如视觉,通过视觉信息对感受野的切割可以表征外部世界相对于人眼的运动方向;对前庭觉来说,前庭器官中的液体受到惯性作用,在头部做加速运动时会向对侧的前庭内壁的应力细胞形成压力,进而把加速度信息转化为生物电信息表征以头部的加速度方向;对听觉来说,声音信号传递到两只耳朵的时间有微弱的差异,也可以通过计算时间差以及单侧耳声音信号强度来判断声音信号的来源方向。

虽然每一种感知都可以单独为大脑提供方向信息,但是生存需要要求我们的大脑做到更多,那就是把合适的多个感知进行整合。比如说,当我们看到视野范围内有一条狗,同时听到一阵不友善的狂吠;如果狗吠的声音也来自于视觉上狗的方向,那我们应该形成的概念是“这只狗不喜欢我,我应该离开”,而不是停留在原地欣赏那只狗,或者推测哪里来的狗吠诸如此类的单信息推断上。这就是整合多个感知觉进而加强判断的能力,被称为多感知整合。它使得大脑能够把来自各个感官的离散信息整合,形成高级的认知判断。

多感知整合体现在哪些方面?以及它和原本的单感知觉相比,有什么优势和劣势?在很多行为学研究当中发现,人类被试在多感知条件下对真实情况的估计误差比单独感官信息的估计误差更小。这一估计不局限于对方向的估计。举个例子,当被试者被蒙蔽双眼,只能用触觉去估计两根长方形板哪根更宽时,被试的判断正确率随着两块板的真实宽度差异呈分布[1]。当两块板的宽度相差悬殊时,被试几乎不可能判断错误;而当两块板的宽度差别微乎其微时,被试判断的正确率趋近于50%。同样的,如果只允许被试用看的方式来判断同时加上一定的噪声使得边界更模糊,被试也会汇报出相似的概率分布。但是,如果既允许被试用眼睛看,又允许同时触摸,这时被试在相同条件下的判断正确率则比单独视觉和单独触觉条件下的正确率都更高。

另一个多感知信息整合的表现是著名的“鸡尾酒会效应”。这个效应是指在一个嘈杂的鸡尾酒会上,噪声的强度非常大,声音的频率成分也非常复杂,但是当我们和朋友面对面聊天时,却可以正常地对话,似乎双方都自动屏蔽了噪声。这当中包含了人的选择性注意机制的作用,但也包含了多感知整合的作用。之所以我们能屏蔽外界的声音去实现对话,很大一部分在于视觉信息与听觉信息发生了整合。当我们全神贯注地看着对方时,我们会下意识地解读唇语——也即谈话对象唇部的运动[2]。这一视觉信息预测了可能听到的话语内容,并且帮助我们提高了听觉的辨识度。这就好像在一堆废品当中分拣有用的金属,视觉信息提供给了我们一块吸铁石,让我们能把金属挑选出来。视觉与听觉的整合同样提高了我们的信息处理效率。

(网图:在现场嘈杂的鸡尾酒会环境和背景音乐中,我们仍可以交流.)

图片来源:http://img.saihuitong.com/2968/img/106792/large/16593e03039.jpg-w1030

当然,多感知整合并不一定总是体现为优势,有时它还会给我们带来幻觉。比如开车等红灯的时候,如果旁车停在我们旁边一起等红灯,而你正在低头玩手机,此时视觉信息仅包含车内的静态信息,以及余光瞄到的车窗外旁车的位置。这时绿灯亮起,旁车起步往前走,而你仍然保持低头的状态,则很可能你会误以为自己的车正在后退,甚至产生后退加速度的错觉。这就是前庭信息错误地与视觉信息发生整合的例子。这样的错觉往往可以总结为感知觉的参照系错误,也即我们把视觉上旁车的位置作为参照系去推测自己的位置,当旁车位置改变的时候,我们仍然参考这个点,从而错误的形成了自己正在运动的概念。

(网图:车窗外的景象给我们提供了参考系,但是当车窗外的视觉信息被一辆可以运动的车所代替时,错误的参考系就容易形成错觉。)

图片来源:http://club.qc188.com/thread-268757-1.html

人脑是如何执行多感知的整合与分离的呢?这牵涉到我们大脑中的一些神经元特性。在多感知脑区MST-d中,发现其中的神经元具有两种典型的感受野:一种是偏好同方向的视觉和前庭信息,另一种是偏好相反的视觉和前庭信息[3]。通过数学论证,我们可以发现正是这两群神经元分别编码了整合与分离的贝叶斯判断,也即两种刺激模式是隶属于同一个源头,还是两个无关的源头[4]。例如,看到眼前的景物向后退,以及感受到向前的加速度,这是否表征了同一个本体运动,还是表明我们眼睛看到的参考系是别的东西,与本体运动方向无关?在这里要引入一个前提。如果大脑真的是以贝叶斯推断的算法在判断方向,那么首先它对外界确定刺激的表征应该具有概率分布特征。即使外部刺激不变,经过多次重复实验,被试对于外部刺激的估计应当呈现概率分布,而不是一个唯一确定的估计。事实上,在很多历史实验当中都印证了这一点,甚至在生活中也经常能感受到这个命题的合理性。基于这个事实,我们可以进一步讨论大脑的贝叶斯计算机制。这里,我们简单展示ZhangWenhao对于多感知整合与分离的贝叶斯判断的数学论证。

假设神经元对于视觉和前庭的响应分别为x1和x2,两种刺激的刺激源头分别为s1和s2,大脑执行的计算就是根据x1和x2来判断s1与s2是否是同一个——也就是看到的视觉信息和前庭感觉到的加速度是否反映着同一个运动。我们用概率的形式表示为:p(s1,s2|x1,x2)

根据贝叶斯理论:

p(s1,s2|x1,x2)∝ p(x1,x2|s1,s2)*p(s1,s2)

假设外部刺激s1与s2相互独立,并且两种信息的加工过程互不干扰,则有:

p(x1,x2|s1,s2)=p(x1|s1)*p(x2|s2)

进一步可推导出

p(s1,s2|x1,x2)∝ p(x1|s1)*p(x2|s2)*p(s1,s2)

如果两个刺激是出自同一源头,也就是大脑判断为多感知整合,设这个源头为s1,则可以对s2求积分:

p(s1|x1,x2)∝ p(x1|s1)*∫p(x2|s2)*p(s1,s2)ds2

对于p(x2|s2)*p(s1,s2) 这一项:

p(x2|s2)*p(s1,s2)∝ p(x2,s1,s2)

所以:∫p(x2|s2)*p(s1,s2) ds2 ∝ ∫p(x2,s1,s2)ds2 = p(x2,s1)

假设我们对于x2的来源没有可依据的先验信息,也就是x2在各个方向上的概率相等,可以得到:p(x2,s1)∝p(x2,s1)/p(x2) = p(s1|x2)

综上所述,p(s1|x1,x2)∝ p(s1|x1)*p(s1|x2)

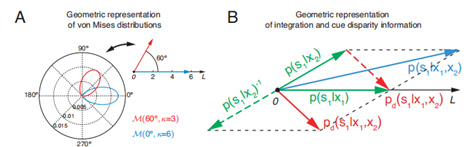

如果把其概率分布设为冯·米塞斯分布的话,可以把上式等价为:M(s1,x1;κ1)* M(s1,x2;κ2)。两个冯米塞斯分布的乘积仍然是一个冯·米塞斯分布:M(s1,s1’;κ),其均值和离散度可以由κejs1’= κ1ejx1+κ2ejx2得到。如果我们把离散度作为刺激响应的可靠性,并表示为向量长度,而均值则是刺激最可能出现的方向,那么大脑中多感知整合就相当于在计算两个刺激的矢量和。相类似的,如果我们把多感知分离视为某一个刺激旋转180度后的多感知整合,则相类似的推导可以得出多感知分离相当于计算两个刺激的矢量差。

(以周期变量计算多感知整合的几何表达,Zhang Wenhao, 2019.) (A) 在极坐标中的两个冯·米塞斯分布以及对应的几何表达(右上角)。一个冯·米塞斯分布可以表达一个向量,其均值为极坐标中的角度,其集中度为向量长度。(B) 多感知整合与分离的集合表达。对于单个刺激的s1后验概率由两个绿色向量表示。整合为蓝色向量,由矢量和得到。分离为红色向量,由矢量差得到。

通过这一论证,我们可以发现生物脑多感知整合的一些规律。例如,从矢量和的形式可以看出,当两种刺激的可靠程度不同时,大脑对于共同来源的估计也不是均等的,而是会偏向信息来源较为可靠的一种刺激。例如,如果给与一个比较强的本体加速度,但是视觉上却没有参照(例如乘坐飞机的时候看着云端很难判断此刻加速度方向),我们会更依赖加速度来判断飞机正在此刻是向上抬升还是下坠。再例如,当两个刺激的来源距离越远时,我们将更倾向于认为这是来自两个不同来源的刺激。比如看到前面有一个人面朝自己并且嘴唇在动,此时后面传来一阵人声,我们也不会把这人声作为面前此人的谈话内容。这些规律在我们生活当中都可以直观地感受到,不过我们的多感知整合机制仍然是亟待解决的问题。

文:张佳伟

【参考文献】

- Ernst, M.O. and M.S. Banks, Humans integrate visual and hapticinformation in a statistically optimal fashion. Nature, 2002. 415(6870): p. 429-33.

- McDermott,J.H., The cocktail party problem.Curr Biol, 2009. 19(22): p. R1024-7.

- Gu,Y., et al., Visual and nonvisual contributionsto three-dimensional heading selectivity in the medial superior temporal area.J Neurosci, 2006. 26(1): p. 73-85.

- Zhang,W.H., et al., Complementary congruent andopposite neurons achieve concurrent multisensory integration and segregation.Elife, 2019. 8.

loading......

loading......